本文以Ubuntu 12.04 LTS Desktop (x64)默认配置为例(机器的内存为4GB),推荐先阅读**《TCP连接的状态与关闭方式,及其对Server与Client的影响》、《Windows系统下的TCP参数优化》**,以了解TCP优化的相关知识。

/proc/sys/net目录

所有的TCP/IP参数都位于/proc/sys/net目录下(请注意,对/proc/sys/net目录下内容的修改都是临时的,任何修改在系统重启后都会丢失),例如下面这些重要的参数:

参数(路径**+**文件)

描述

默认值

优化值

/proc/sys/net/core/rmem_default

默认的TCP数据接收窗口大小(字节)。

229376

256960

/proc/sys/net/core/rmem_max

最大的TCP数据接收窗口(字节)。

131071

513920

/proc/sys/net/core/wmem_default

默认的TCP数据发送窗口大小(字节)。

229376

256960

/proc/sys/net/core/wmem_max

最大的TCP数据发送窗口(字节)。

131071

513920

/proc/sys/net/core/netdev_max_backlog

在每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

1000

2000

/proc/sys/net/core/somaxconn

定义了系统中每一个端口最大的监听队列的长度,这是个全局的参数。

128

2048

/proc/sys/net/core/optmem_max

表示每个套接字所允许的最大缓冲区的大小。

20480

81920

/proc/sys/net/ipv4/tcp_mem

确定TCP栈应该如何反映内存使用,每个值的单位都是内存页(通常是4KB)。第一个值是内存使用的下限;第二个值是内存压力模式开始对缓冲区使用应用压力的上限;第三个值是内存使用的上限。在这个层次上可以将报文丢弃,从而减少对内存的使用。对于较大的BDP可以增大这些值(注意,其单位是内存页而不是字节)。

94011 125351 188022

131072 262144 524288

/proc/sys/net/ipv4/tcp_rmem

为自动调优定义socket使用的内存。第一个值是为socket接收缓冲区分配的最少字节数;第二个值是默认值(该值会被rmem_default覆盖),缓冲区在系统负载不重的情况下可以增长到这个值;第三个值是接收缓冲区空间的最大字节数(该值会被rmem_max覆盖)。

4096 87380 4011232

8760 256960 4088000

/proc/sys/net/ipv4/tcp_wmem

为自动调优定义socket使用的内存。第一个值是为socket发送缓冲区分配的最少字节数;第二个值是默认值(该值会被wmem_default覆盖),缓冲区在系统负载不重的情况下可以增长到这个值;第三个值是发送缓冲区空间的最大字节数(该值会被wmem_max覆盖)。

4096 16384 4011232

8760 256960 4088000

/proc/sys/net/ipv4/tcp_keepalive_time

TCP发送keepalive探测消息的间隔时间(秒),用于确认TCP连接是否有效。

7200

1800

/proc/sys/net/ipv4/tcp_keepalive_intvl

探测消息未获得响应时,重发该消息的间隔时间(秒)。

75

30

/proc/sys/net/ipv4/tcp_keepalive_probes

在认定TCP连接失效之前,最多发送多少个keepalive探测消息。

9

3

/proc/sys/net/ipv4/tcp_sack

启用有选择的应答(1表示启用),通过有选择地应答乱序接收到的报文来提高性能,让发送者只发送丢失的报文段,(对于广域网通信来说)这个选项应该启用,但是会增加对CPU的占用。

1

1

/proc/sys/net/ipv4/tcp_fack

启用转发应答,可以进行有选择应答(SACK)从而减少拥塞情况的发生,这个选项也应该启用。

1

1

/proc/sys/net/ipv4/tcp_timestamps

TCP时间戳(会在TCP包头增加12个字节),以一种比重发超时更精确的方法(参考RFC 1323)来启用对RTT 的计算,为实现更好的性能应该启用这个选项。

1

1

/proc/sys/net/ipv4/tcp_window_scaling

启用RFC 1323定义的window scaling,要支持超过64KB的TCP窗口,必须启用该值(1表示启用),TCP窗口最大至1GB,TCP连接双方都启用时才生效。

1

1

/proc/sys/net/ipv4/tcp_syncookies

表示是否打开TCP同步标签(syncookie),内核必须打开了CONFIG_SYN_COOKIES项进行编译,同步标签可以防止一个套接字在有过多试图连接到达时引起过载。

1

1

/proc/sys/net/ipv4/tcp_tw_reuse

表示是否允许将处于TIME-WAIT状态的socket(TIME-WAIT的端口)用于新的TCP连接 。

0

1

/proc/sys/net/ipv4/tcp_tw_recycle

能够更快地回收TIME-WAIT套接字。

0

1

/proc/sys/net/ipv4/tcp_fin_timeout

对于本端断开的socket连接,TCP保持在FIN-WAIT-2状态的时间(秒)。对方可能会断开连接或一直不结束连接或不可预料的进程死亡。

60

30

/proc/sys/net/ipv4/ip_local_port_range

表示TCP/UDP协议允许使用的本地端口号

32768 61000

1024 65000

/proc/sys/net/ipv4/tcp_max_syn_backlog

对于还未获得对方确认的连接请求,可保存在队列中的最大数目。如果服务器经常出现过载,可以尝试增加这个数字。

2048

2048

/proc/sys/net/ipv4/tcp_low_latency

允许TCP/IP栈适应在高吞吐量情况下低延时的情况,这个选项应该禁用。

0

/proc/sys/net/ipv4/tcp_westwood

启用发送者端的拥塞控制算法,它可以维护对吞吐量的评估,并试图对带宽的整体利用情况进行优化,对于WAN 通信来说应该启用这个选项。

0

/proc/sys/net/ipv4/tcp_bic

为快速长距离网络启用Binary Increase Congestion,这样可以更好地利用以GB速度进行操作的链接,对于WAN通信应该启用这个选项。

1

/etc/sysctl.conf文件 /etc/sysctl.conf是一个允许你改变正在运行中的Linux系统的接口。它包含一些TCP/IP堆栈和虚拟内存系统的高级选项,可用来控制Linux网络配置,由于/proc/sys/net目录内容的临时性,建议把TCPIP参数的修改添加到/etc/sysctl.conf文件, 然后保存文件,使用命令“/sbin/sysctl –p”使之立即生效。具体修改方案参照上文:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

| net.core.rmem_default = 256960

net.core.rmem_max = 513920

net.core.wmem_default = 256960

net.core.wmem_max = 513920

net.core.netdev_max_backlog = 2000

net.core.somaxconn = 2048

net.core.optmem_max = 81920

net.ipv4.tcp_mem = 131072 262144 524288

net.ipv4.tcp_rmem = 8760 256960 4088000

net.ipv4.tcp_wmem = 8760 256960 4088000

net.ipv4.tcp_keepalive_time = 1800

net.ipv4.tcp_keepalive_intvl = 30

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_sack = 1

net.ipv4.tcp_fack = 1

net.ipv4.tcp_timestamps = 1

net.ipv4.tcp_window_scaling = 1

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_fin_timeout = 30

net.ipv4.ip_local_port_range = 1024 65000

net.ipv4.tcp_max_syn_backlog = 2048

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

| 这儿所列参数是老男孩老师生产中常用的参数:

net.ipv4.tcp_syn_retries = 1

net.ipv4.tcp_synack_retries = 1

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_keepalive_intvl =15

net.ipv4.tcp_retries2 = 5

net.ipv4.tcp_fin_timeout = 2

net.ipv4.tcp_max_tw_buckets = 36000

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_orphans = 32768

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.tcp_wmem = 8192 131072 16777216

net.ipv4.tcp_rmem = 32768 131072 16777216

net.ipv4.tcp_mem = 786432 1048576 1572864

net.ipv4.ip_local_port_range = 1024 65000

net.ipv4.ip_conntrack_max = 65536

net.ipv4.netfilter.ip_conntrack_max=65536

net.ipv4.netfilter.ip_conntrack_tcp_timeout_established=180

net.core.somaxconn = 16384

net.core.netdev_max_backlog = 16384

对比网上其他人的生产环境优化参数,需要优化的参数基本差不多,只是值有相应的变化。具体优化值要参考应用场景,这儿所列只是常用优化参数,是否适合,可在上面查看该参数描述,理解后,再根据自己生产环境而设。其它相关linux内核参数调整文章:Linux内核参数优化flandycheng.blog.51cto.com/855176/4767…优化linux的内核参数来提高服务器并发处理能力 www.ha97.com/4396.htmlnginx做web服务器linux内核参数优化

|

如果希望增加更多测试节点,直接编辑源码,修改修改即可。(节点来自各地运营商DNS)

如果希望增加更多测试节点,直接编辑源码,修改修改即可。(节点来自各地运营商DNS)

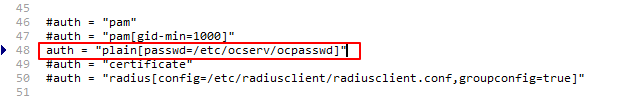

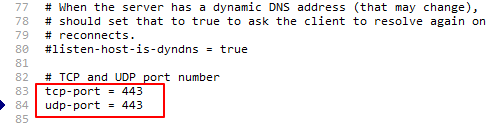

2、默认的监听端口为443,如果你的服务器上跑着HTTPS的WEB站点,那么443端口肯定是被占用了的,所以如果有需求的话,可以更改下面的值:

2、默认的监听端口为443,如果你的服务器上跑着HTTPS的WEB站点,那么443端口肯定是被占用了的,所以如果有需求的话,可以更改下面的值: 3、Anyconnect有一个设置连接欢迎信息的功能,也就是你在连接的时候会弹出一个提示框,提示框的内容就可以自行设置,如有需要可以更改下面的值:

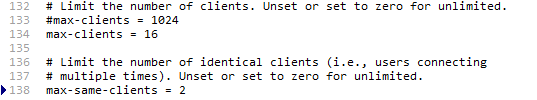

3、Anyconnect有一个设置连接欢迎信息的功能,也就是你在连接的时候会弹出一个提示框,提示框的内容就可以自行设置,如有需要可以更改下面的值: 4、Anyconnect可以限制最大允许连接的设备数量,如有需要可以更改下面这两个值:

4、Anyconnect可以限制最大允许连接的设备数量,如有需要可以更改下面这两个值: 5、更改服务器证书以及私钥的路径为我们刚才移动的路径:

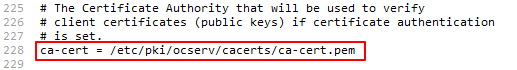

5、更改服务器证书以及私钥的路径为我们刚才移动的路径: 6、更改CA证书的路径为我们刚才移动的路径:

6、更改CA证书的路径为我们刚才移动的路径: 7、取消如下几个参数的注释(去掉#号就是去掉注释):

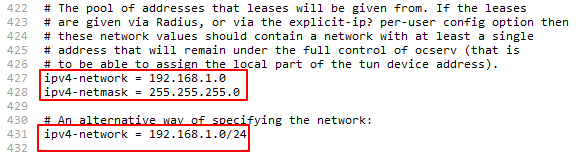

7、取消如下几个参数的注释(去掉#号就是去掉注释): 8、去掉如下参数的注释以及设置DNS服务器地址:

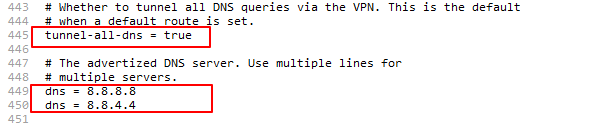

8、去掉如下参数的注释以及设置DNS服务器地址: 确定你已经修改好上面的内容,然后保存即可。 现在来创建一个VPN用户:

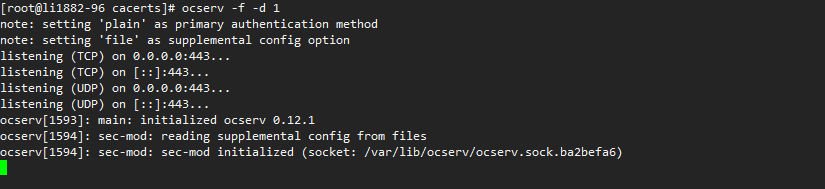

确定你已经修改好上面的内容,然后保存即可。 现在来创建一个VPN用户: 确定正常后按键盘组合键Ctrl+C退出运行,现在我们就可以直接用systemctl来管理Ocserv的进程。 设置Ocserv开机启动:

确定正常后按键盘组合键Ctrl+C退出运行,现在我们就可以直接用systemctl来管理Ocserv的进程。 设置Ocserv开机启动: 接着点击“连接”-“添加VPN连接”,按如下图配置:

接着点击“连接”-“添加VPN连接”,按如下图配置:  现在就可以连接了,会提示你不信任的服务器,点“继续”:

现在就可以连接了,会提示你不信任的服务器,点“继续”:  然后就是输入用户名密码了,这里就不多说了,用户名和密码就是之前你自己在终端内创建的那个,如果用户名和密码验证正确的话,那么最后就会弹出你设置的欢迎信息:

然后就是输入用户名密码了,这里就不多说了,用户名和密码就是之前你自己在终端内创建的那个,如果用户名和密码验证正确的话,那么最后就会弹出你设置的欢迎信息:  现在就开始爱国吧。。。 写在最后: 其他客户端的配置都大同小异。因为我们是自签的证书,所以不管在哪个客户端上只要把“阻止不信任的服务器”这种类似的功能关闭就行了。

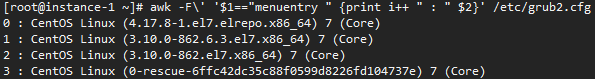

现在就开始爱国吧。。。 写在最后: 其他客户端的配置都大同小异。因为我们是自签的证书,所以不管在哪个客户端上只要把“阻止不信任的服务器”这种类似的功能关闭就行了。 接下来设置grub2默认的启动项为0,如果你的4.x内核启动编号不是0就把下面命令的0改成对应你自己的:

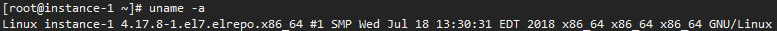

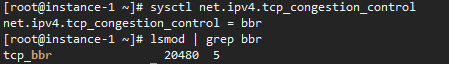

接下来设置grub2默认的启动项为0,如果你的4.x内核启动编号不是0就把下面命令的0改成对应你自己的: 所以接下来就是开启BBR了,直接依次执行下面的三条命令即可完成开启BBR的操作:

所以接下来就是开启BBR了,直接依次执行下面的三条命令即可完成开启BBR的操作:

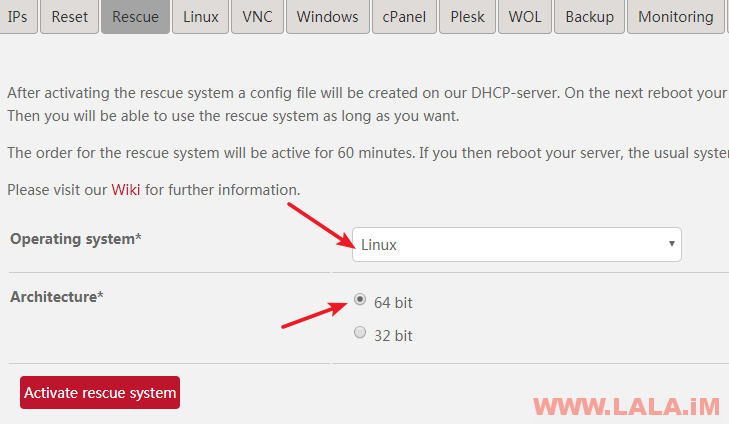

然后还是和往常一样,执行硬重启:

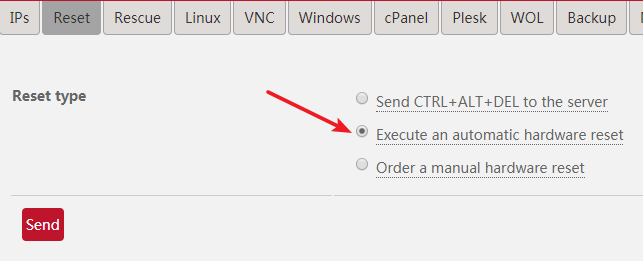

然后还是和往常一样,执行硬重启:  重启完成后,使用Xshell,登录到救援系统内,执行命令:

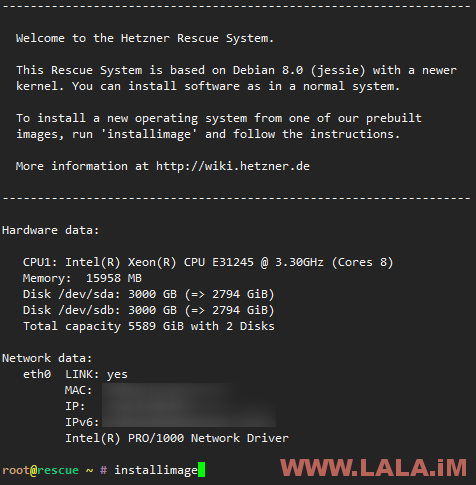

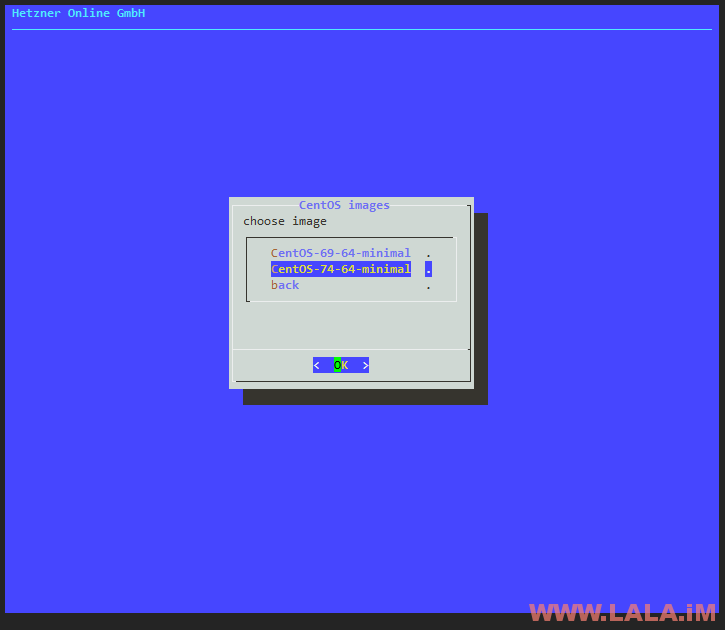

重启完成后,使用Xshell,登录到救援系统内,执行命令: 选择CentOS:

选择CentOS:  选择7.4版本:

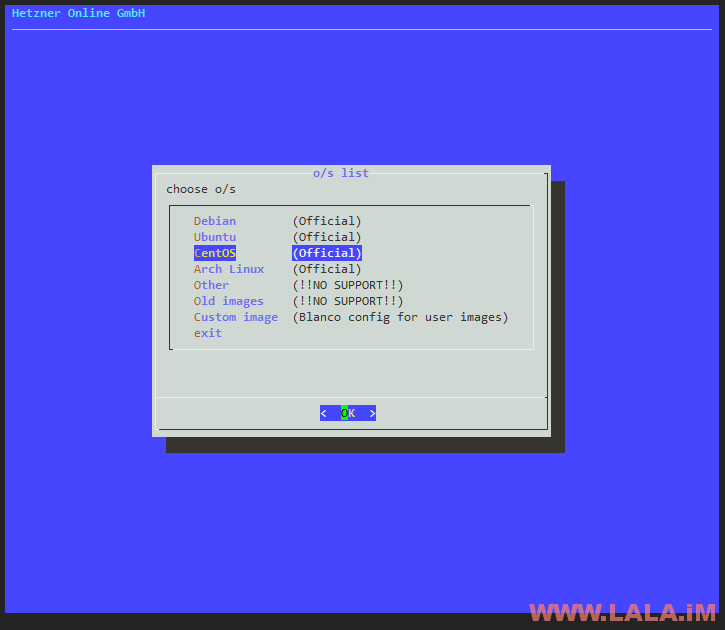

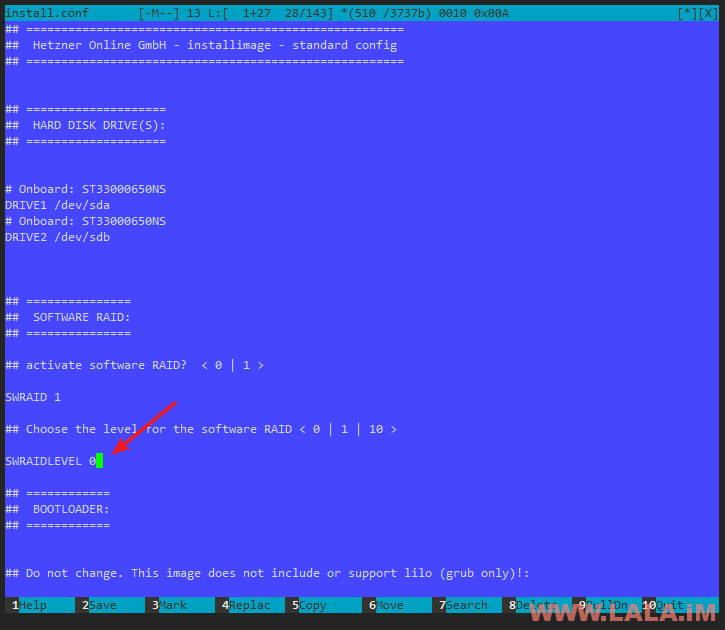

选择7.4版本:  做RAID0:

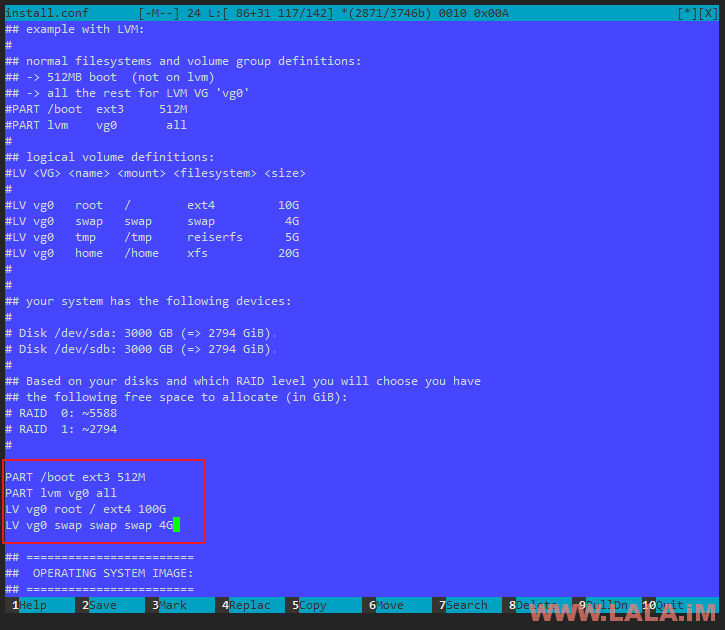

做RAID0:  接下来到了一个非常关键的地方了,就是使用LVM进行硬盘分区,我们需要注意的是SolusVM只需要我们创建卷组(VG)即可,剩下的硬盘空间SolusVM会根据虚拟机所需的硬盘大小来自动划分。所以我们分区的时候,只把CentOS必要的文件系统分出来,其他的空间全部不划分,如图所示:

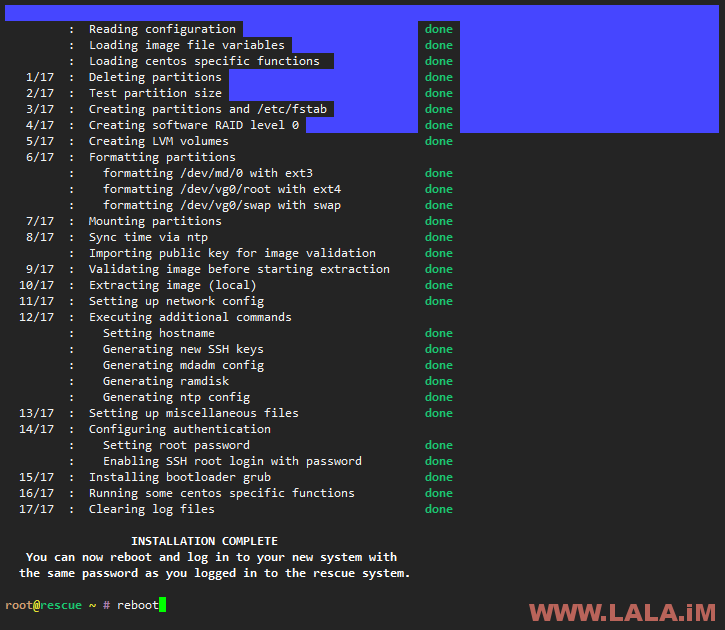

接下来到了一个非常关键的地方了,就是使用LVM进行硬盘分区,我们需要注意的是SolusVM只需要我们创建卷组(VG)即可,剩下的硬盘空间SolusVM会根据虚拟机所需的硬盘大小来自动划分。所以我们分区的时候,只把CentOS必要的文件系统分出来,其他的空间全部不划分,如图所示:  确认你的分区配置没问题后,按键盘F10,保存然后就是按几个回车,程序就会自动帮你装系统了。安装完成后,执行命令重启:

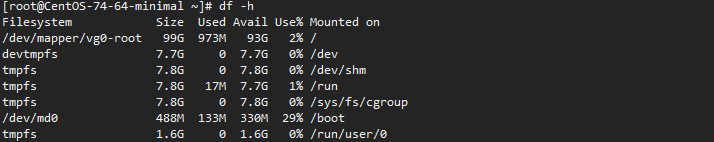

确认你的分区配置没问题后,按键盘F10,保存然后就是按几个回车,程序就会自动帮你装系统了。安装完成后,执行命令重启: 重启完成后,就可以登录到刚新装的CentOS7内了,可以看到硬盘只划分了100G,我这台独立服务器是6T的硬盘,剩下的容量这里都没有显示挂载,那么就是正常的:

重启完成后,就可以登录到刚新装的CentOS7内了,可以看到硬盘只划分了100G,我这台独立服务器是6T的硬盘,剩下的容量这里都没有显示挂载,那么就是正常的:  现在我们就可以在这台独立服务器内安装SolusVM被控了,执行如下两条命令即可开始安装:

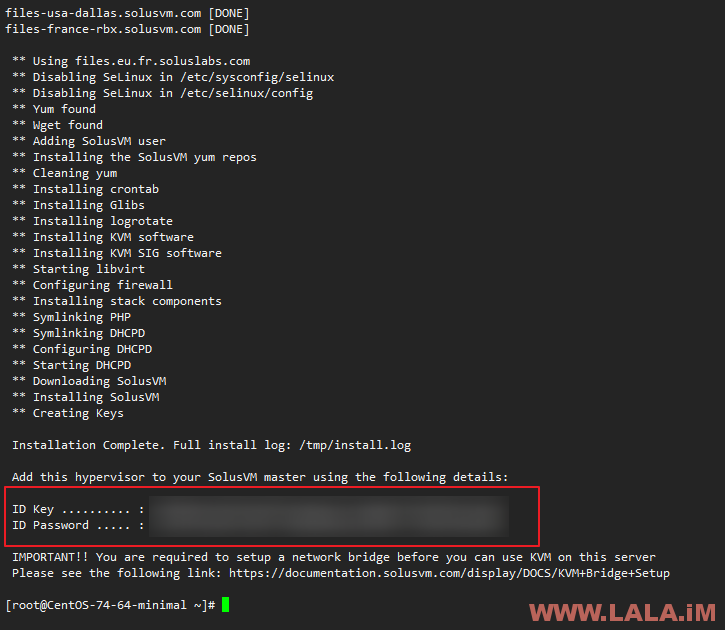

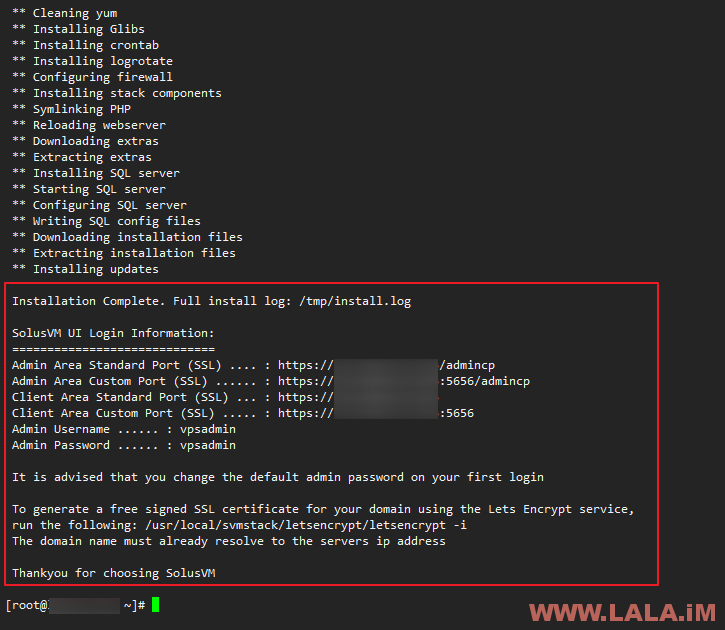

现在我们就可以在这台独立服务器内安装SolusVM被控了,执行如下两条命令即可开始安装: 接下来就是等了,大概5分钟左右,安装就可以完成,成功后会回显给你这台被控的KEY和密码信息,这两个信息务必要妥善保管:

接下来就是等了,大概5分钟左右,安装就可以完成,成功后会回显给你这台被控的KEY和密码信息,这两个信息务必要妥善保管:  如果你是开OpenVZ的小鸡,那么可以说SolusVM是开箱即用的,但我们要开的是全虚拟化的KVM,这里我们就还需要手动配置网卡的桥接。在Hetzner的独立服务器上,我这里给出一个可行的桥接方案。(不保证在别的独立服务器上也可用,因为每个服务器的网络环境都不同) 安装桥接依赖,这个其实SolusVM自动安装的时候应该是已经装好了的:

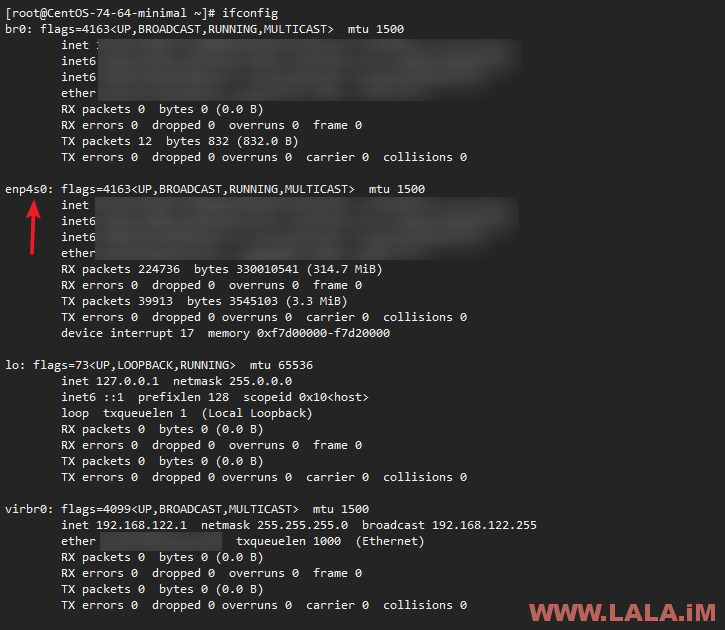

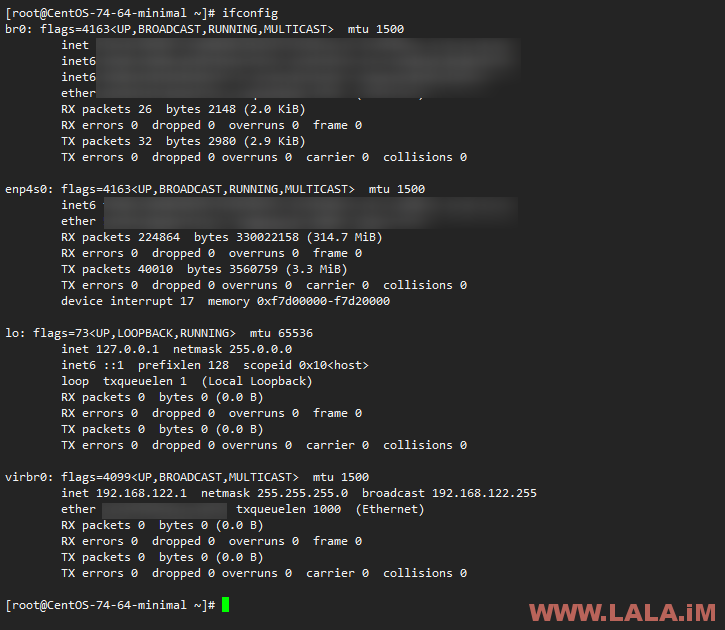

如果你是开OpenVZ的小鸡,那么可以说SolusVM是开箱即用的,但我们要开的是全虚拟化的KVM,这里我们就还需要手动配置网卡的桥接。在Hetzner的独立服务器上,我这里给出一个可行的桥接方案。(不保证在别的独立服务器上也可用,因为每个服务器的网络环境都不同) 安装桥接依赖,这个其实SolusVM自动安装的时候应该是已经装好了的: 接着我们修改原来默认的公网网卡配置:

接着我们修改原来默认的公网网卡配置: 至此,SolusVM的被控端我们就配置完成了,接下来是主控的安装。 首先我们要把主控装到另外一台VPS上,我个人建议主控和被控的网络连通性要比较好才行,以免后期在生产环境的时候出现一些不必要的麻烦。比如我现在的被控是一台德国机器,那么用来搭建主控的VPS最好也是德国的,所以我这里选择把主控装在Linode的德国机房。 安装主控和安装被控需要执行的命令是一模一样的:

至此,SolusVM的被控端我们就配置完成了,接下来是主控的安装。 首先我们要把主控装到另外一台VPS上,我个人建议主控和被控的网络连通性要比较好才行,以免后期在生产环境的时候出现一些不必要的麻烦。比如我现在的被控是一台德国机器,那么用来搭建主控的VPS最好也是德国的,所以我这里选择把主控装在Linode的德国机房。 安装主控和安装被控需要执行的命令是一模一样的: 稍等片刻,程序安装完成后,会回显给你主控面板的各类信息,如图所示:

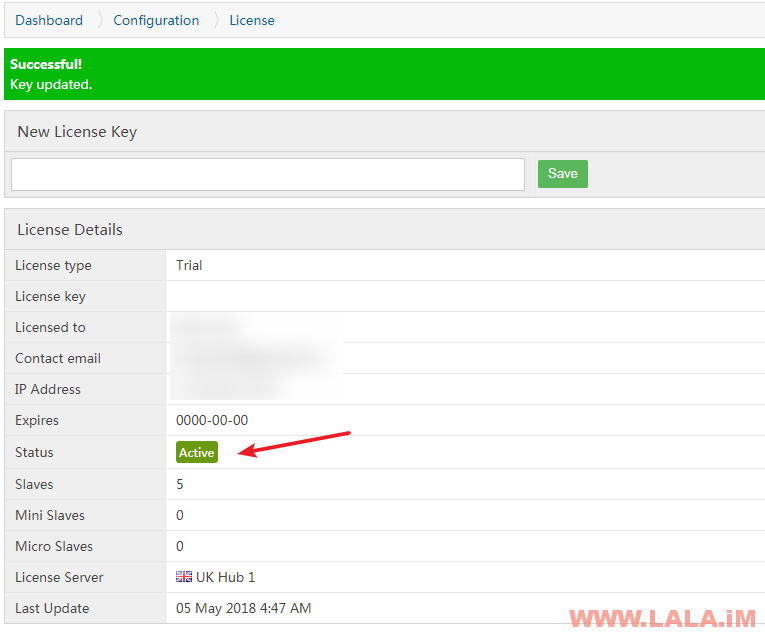

稍等片刻,程序安装完成后,会回显给你主控面板的各类信息,如图所示:  默认的管理员账号密码都是vpsadmin, 我们登录进去首先要输入授权码,授权成功后如图所示:

默认的管理员账号密码都是vpsadmin, 我们登录进去首先要输入授权码,授权成功后如图所示:  接着更改系统默认的管理员密码:

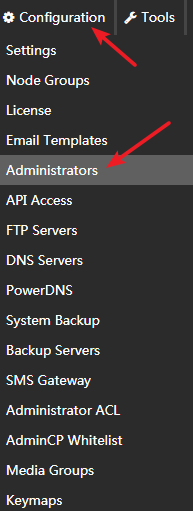

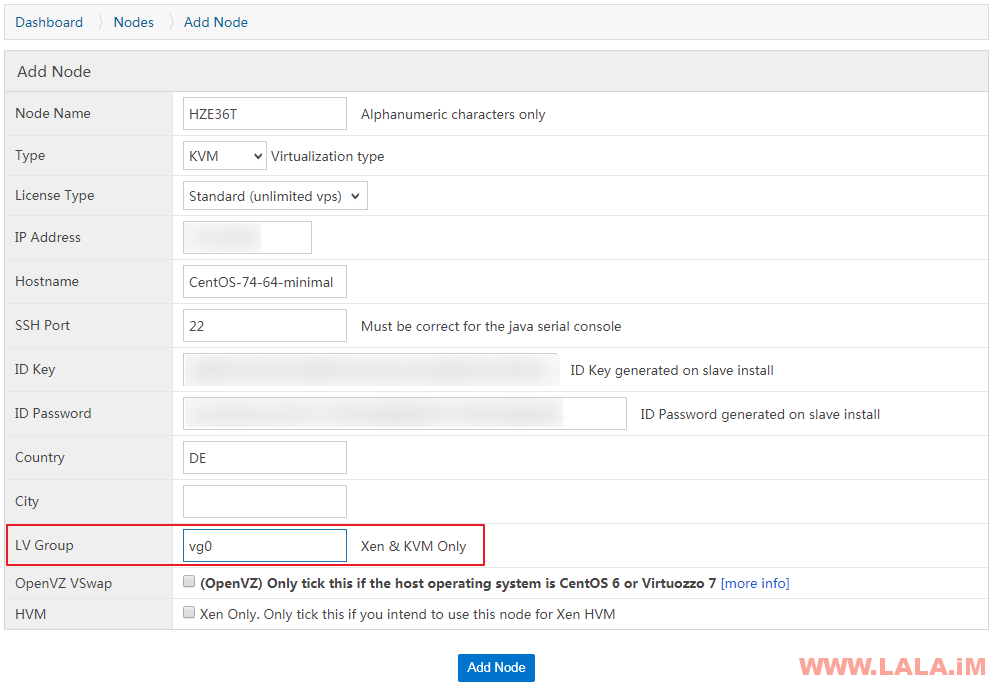

接着更改系统默认的管理员密码:  现在我们就需要把主控和被控进行对接了。首先点击Nodes-Add Node,然后按如下图格式填写:

现在我们就需要把主控和被控进行对接了。首先点击Nodes-Add Node,然后按如下图格式填写:  注: 1、LV Group这个值,一定要填写和我们之前分区指定的名字一样,我最开始配置LVM的时候,用的卷组名就是vg0,所以这里也要填vg0,如果你不是用的这个名字,就要自行更改。 2、IP地址填你的独立服务器IP地址,也就是被控的IP地址。 3、KEY和密码就是之前你装被控完成后回显给你的那些信息。 被控添加完成后,我们现在来加下IP。首先点击IP Blocks-Add IPv4 Block,然后按如图填写:

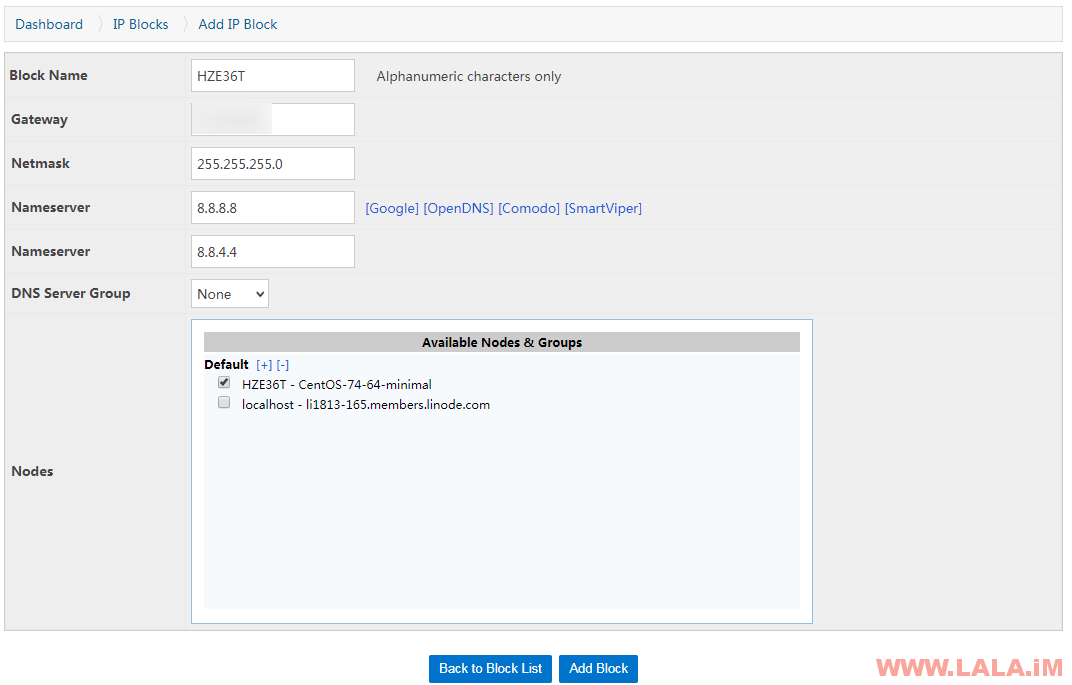

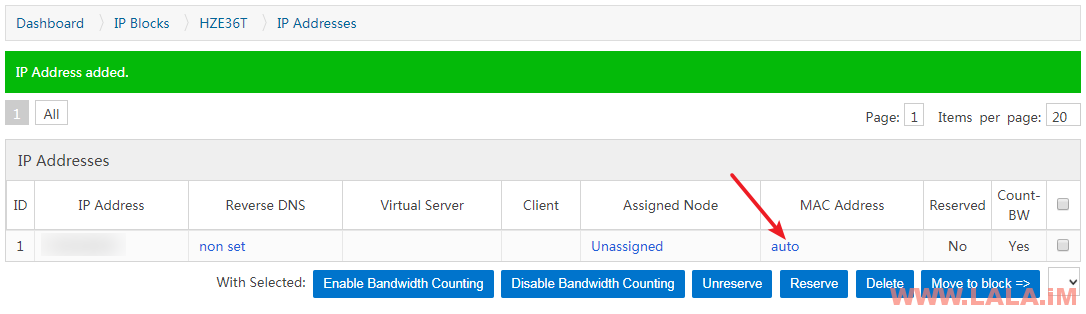

注: 1、LV Group这个值,一定要填写和我们之前分区指定的名字一样,我最开始配置LVM的时候,用的卷组名就是vg0,所以这里也要填vg0,如果你不是用的这个名字,就要自行更改。 2、IP地址填你的独立服务器IP地址,也就是被控的IP地址。 3、KEY和密码就是之前你装被控完成后回显给你的那些信息。 被控添加完成后,我们现在来加下IP。首先点击IP Blocks-Add IPv4 Block,然后按如图填写:  注: 1、在这个配置里面,只需要注意把Gateway(网关)IP填写正确即可,这个网关IP就是之前被控网卡配置文件route-br0里面的IP地址。 2、Node这里一定要勾选上我们刚才新添加的,这里我是HZE36T。 现在我们就可以在这个IP Blocks里面加IP了:

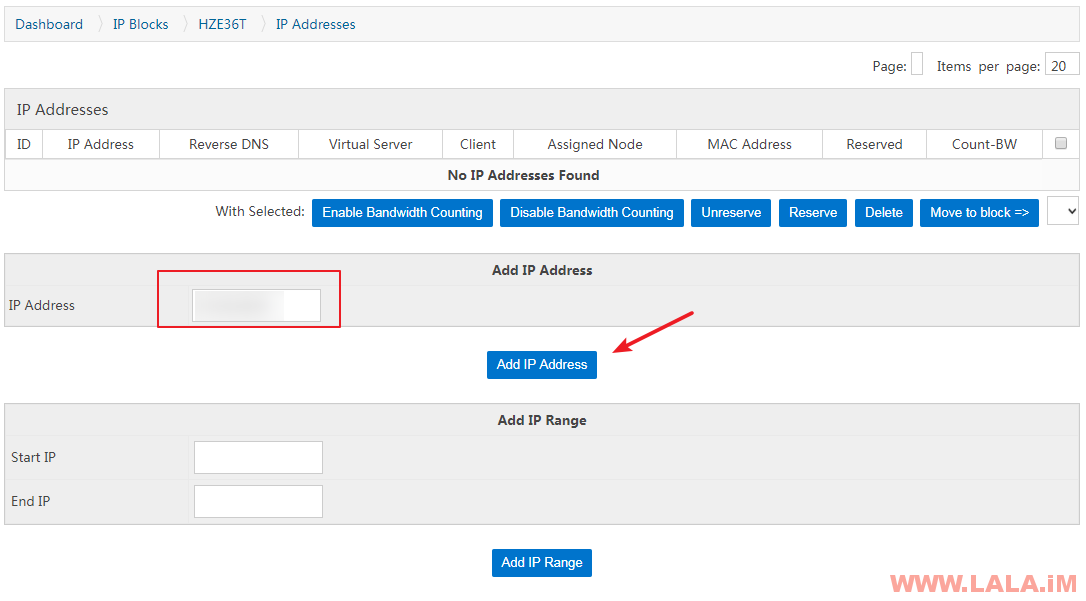

注: 1、在这个配置里面,只需要注意把Gateway(网关)IP填写正确即可,这个网关IP就是之前被控网卡配置文件route-br0里面的IP地址。 2、Node这里一定要勾选上我们刚才新添加的,这里我是HZE36T。 现在我们就可以在这个IP Blocks里面加IP了:  这里有一个问题,由于Hetzner的IP策略是IP必须绑定一个MAC地址的,所以我们在SolusVM后台配置这里不能用自动生成MAC的模式,一定要把MAC改成Hetzner绑定的那个。 首先我们在Hetzner后台找到你买的IP,后面有一个电脑的小图标,点击它:

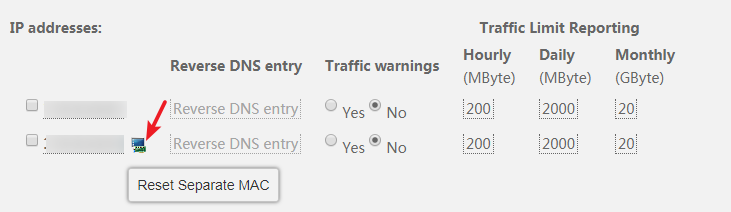

这里有一个问题,由于Hetzner的IP策略是IP必须绑定一个MAC地址的,所以我们在SolusVM后台配置这里不能用自动生成MAC的模式,一定要把MAC改成Hetzner绑定的那个。 首先我们在Hetzner后台找到你买的IP,后面有一个电脑的小图标,点击它:  这样Hetzner就会给这个IP绑定一个物理的MAC地址,如图所示:

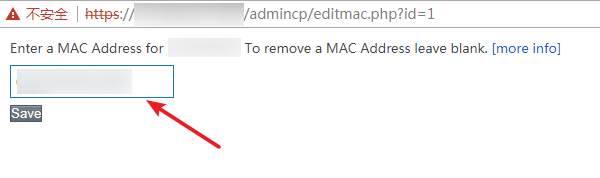

这样Hetzner就会给这个IP绑定一个物理的MAC地址,如图所示:  然后我们就可以把这个MAC地址绑定到我们刚添加的IP上了,首先点击如图所示位置:

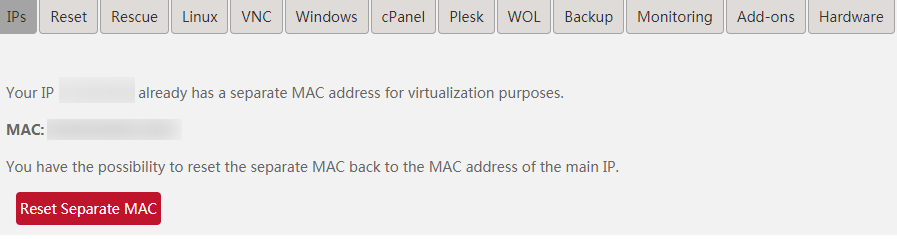

然后我们就可以把这个MAC地址绑定到我们刚添加的IP上了,首先点击如图所示位置:  添加一下即可:

添加一下即可:  现在我们来准备一些KVM系统模版,SolusVM官方默认是提供一些系统模版的,我们可以到这里查看:

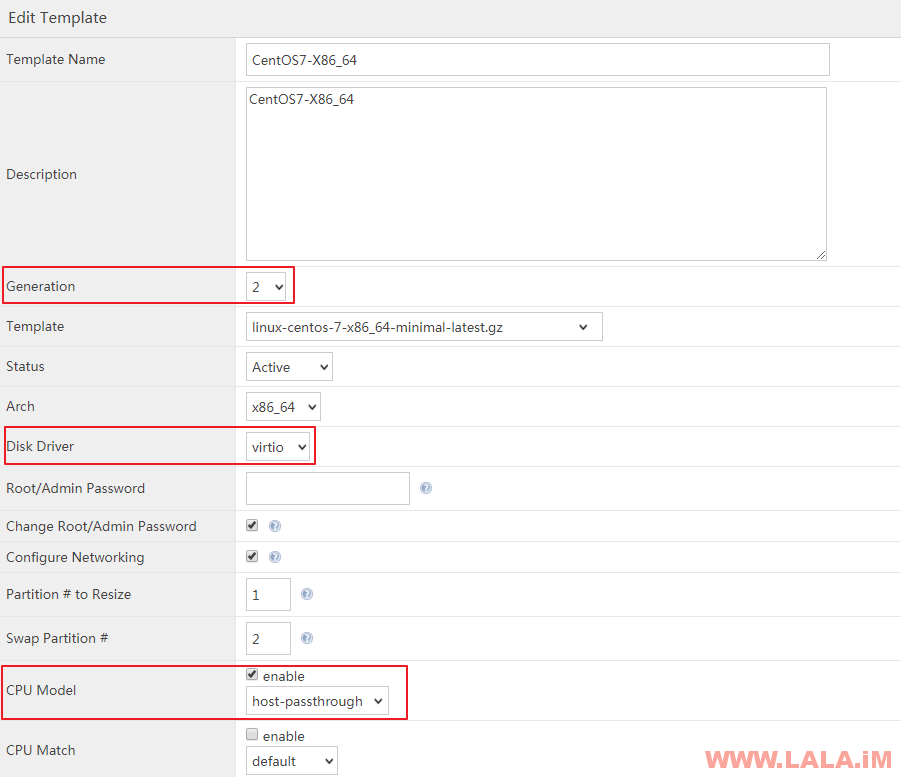

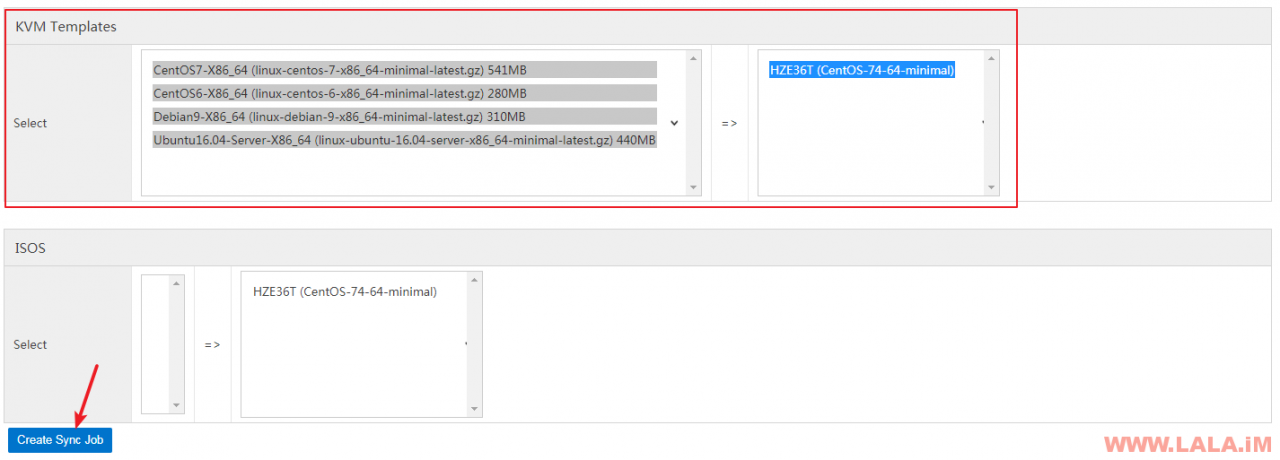

现在我们来准备一些KVM系统模版,SolusVM官方默认是提供一些系统模版的,我们可以到这里查看:  注: 1、Generation这个值默认是1,但我们一定要改成2,否则虚拟机无法正常开机。 2、Disk Driver一定要选择virtio。 3、Arch一定要选择x86_64,因为我们的系统模版是基于64位架构制作的。 4、建议开启CPU Model,并把模式改为host-passthrough。我个人是极其讨厌买到手的KVM机器查看CPU信息查不到型号的,所以用这个模式可以直接把母鸡的CPU型号暴露在虚拟机内,虚拟机内可以直接显示母鸡所使用的具体CPU型号。 OK,在添加好了系统模版后,我们还需要把现有的这些系统模版同步到被控中去,因为现在的这些模版文件都还在主控端上。 点击Media-Media Sync,选中我们要同步的模版,然后选中要同步的被控,提交即可:

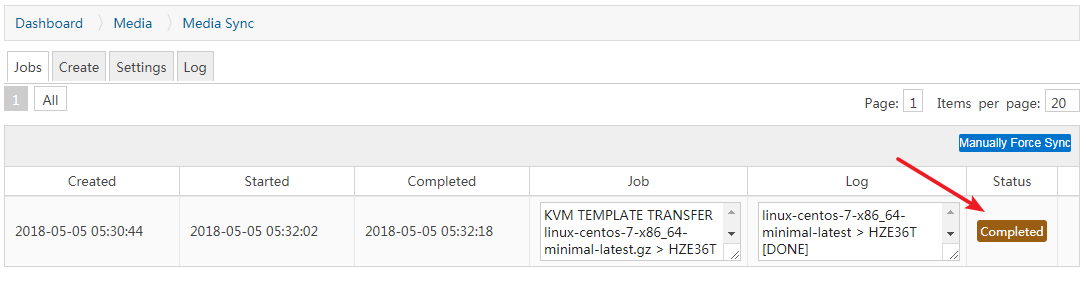

注: 1、Generation这个值默认是1,但我们一定要改成2,否则虚拟机无法正常开机。 2、Disk Driver一定要选择virtio。 3、Arch一定要选择x86_64,因为我们的系统模版是基于64位架构制作的。 4、建议开启CPU Model,并把模式改为host-passthrough。我个人是极其讨厌买到手的KVM机器查看CPU信息查不到型号的,所以用这个模式可以直接把母鸡的CPU型号暴露在虚拟机内,虚拟机内可以直接显示母鸡所使用的具体CPU型号。 OK,在添加好了系统模版后,我们还需要把现有的这些系统模版同步到被控中去,因为现在的这些模版文件都还在主控端上。 点击Media-Media Sync,选中我们要同步的模版,然后选中要同步的被控,提交即可:  稍等片刻,一旦这里显示Completed,即代表模版同步完成:

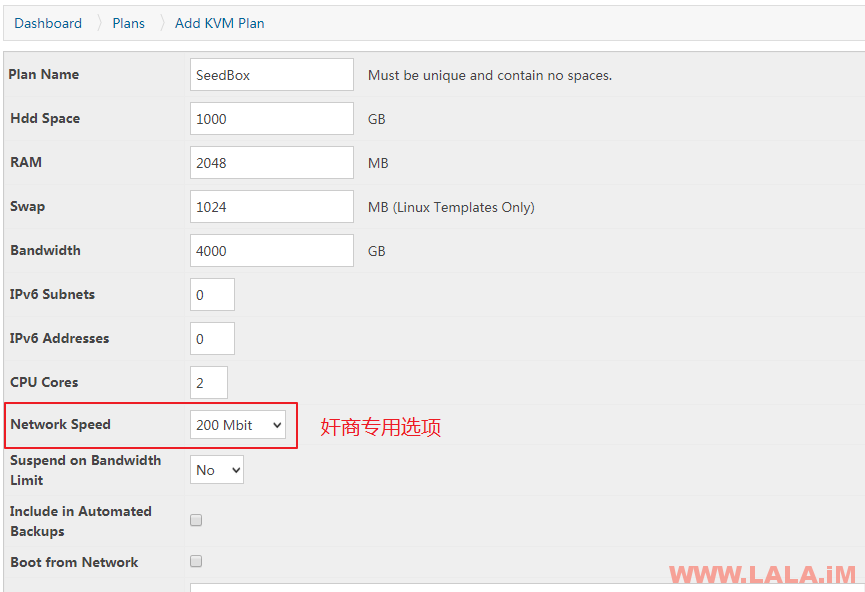

稍等片刻,一旦这里显示Completed,即代表模版同步完成:  现在我们就可以来添加一个虚拟机套餐了,点击Plans-Add KVM Plan,按你自己的需求设置一个合适的套餐:

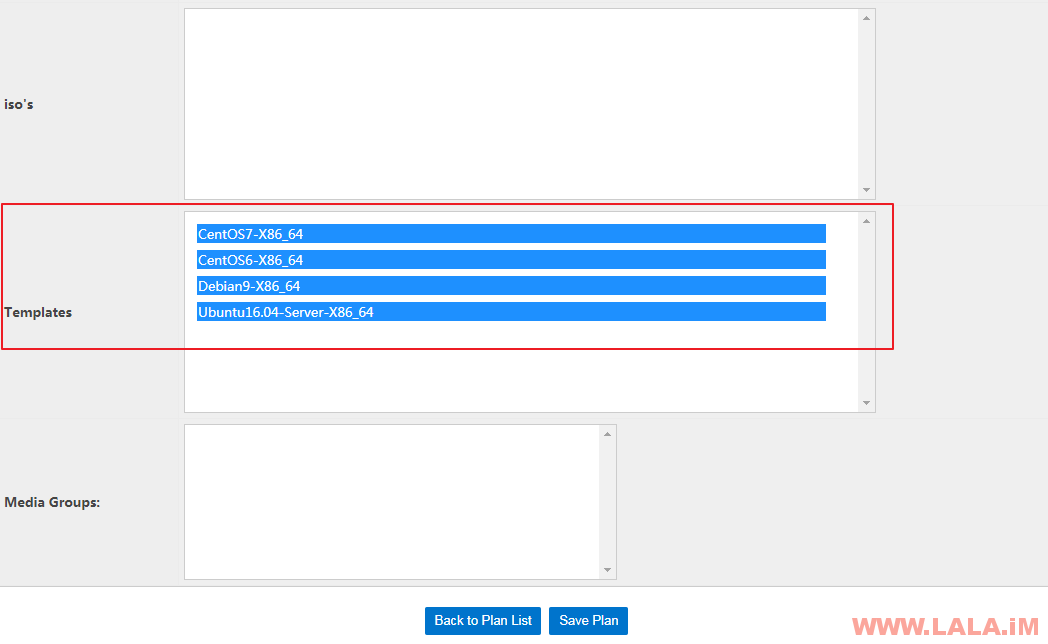

现在我们就可以来添加一个虚拟机套餐了,点击Plans-Add KVM Plan,按你自己的需求设置一个合适的套餐:  注意,下面这个模版一定要选择,否则客户在面板里面找不到可以重装的系统:

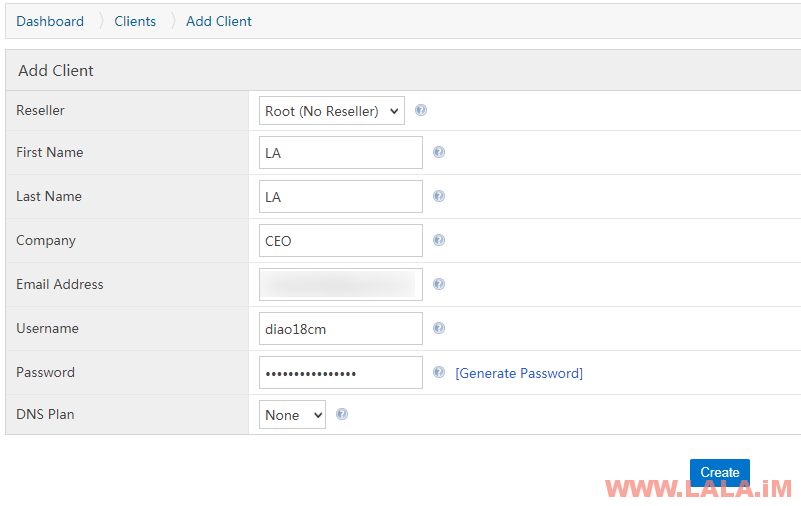

注意,下面这个模版一定要选择,否则客户在面板里面找不到可以重装的系统:  现在我们就可以来尝试开通一台KVM架构的VPS了,需要注意的是,在SolusVM的后台中,开设VPS必须要创建一个用户账户,点击左侧的Add Client,填写相应信息即可:

现在我们就可以来尝试开通一台KVM架构的VPS了,需要注意的是,在SolusVM的后台中,开设VPS必须要创建一个用户账户,点击左侧的Add Client,填写相应信息即可:  接着点击Virtual ServersAdd-Virtual Server,如图选择KVM架构:

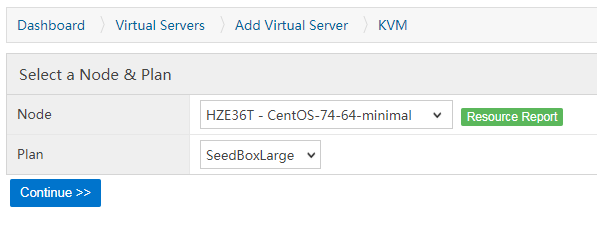

接着点击Virtual ServersAdd-Virtual Server,如图选择KVM架构:  选择我们刚创建的套餐:

选择我们刚创建的套餐:  设置主机名、操作系统:

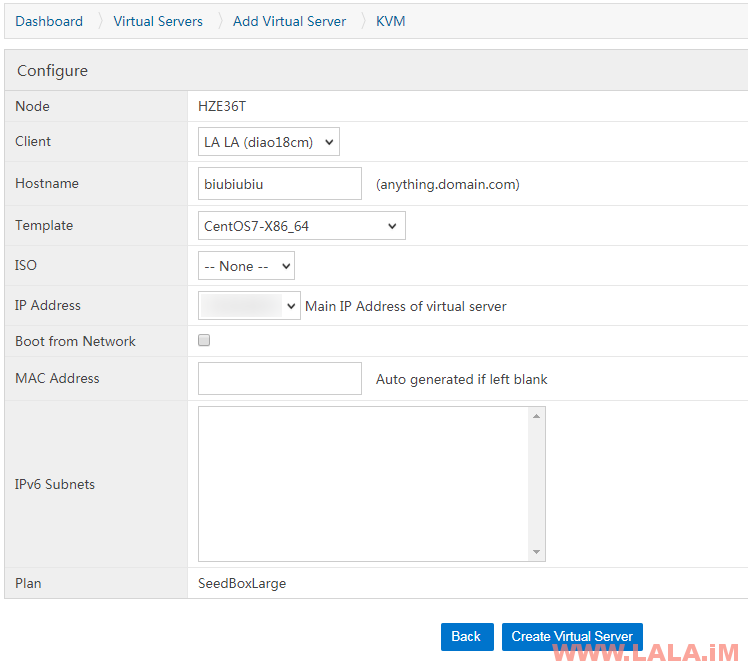

设置主机名、操作系统:  VPS就创建好了:

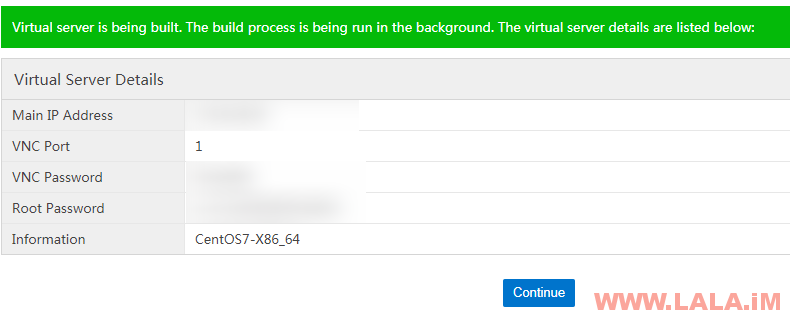

VPS就创建好了:  稍等片刻儿,用户在前台也能管理VPS了:

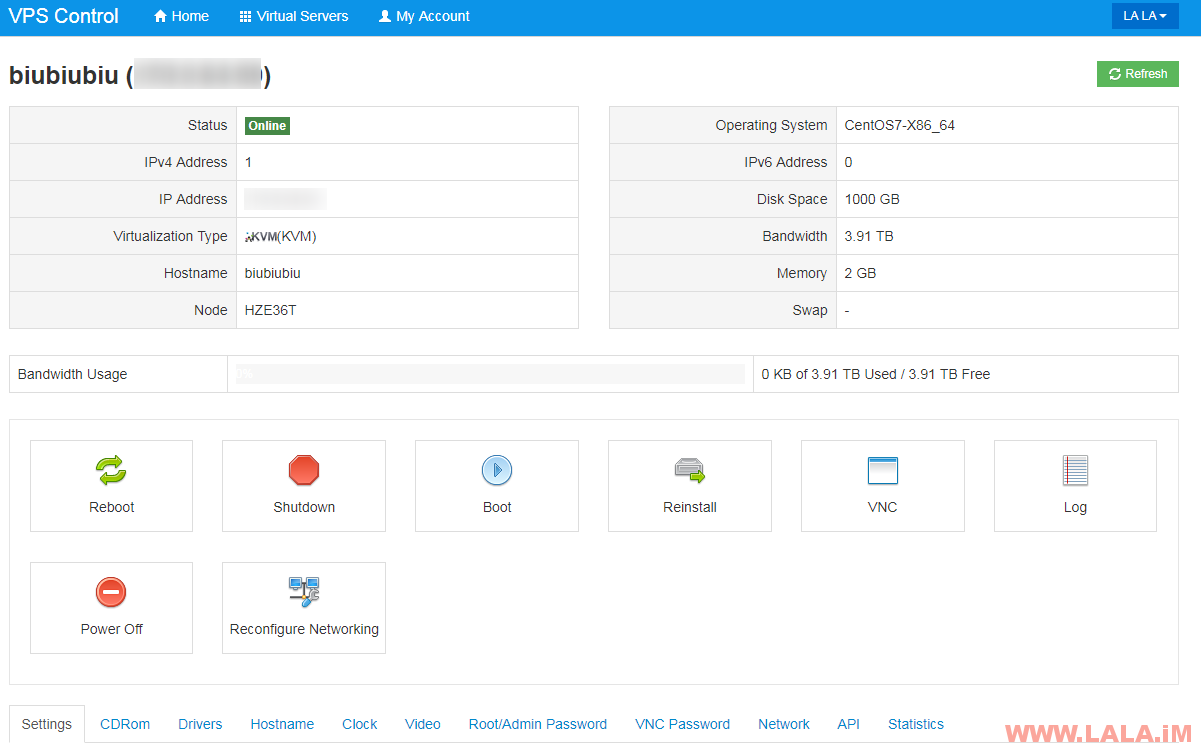

稍等片刻儿,用户在前台也能管理VPS了:  最后使用Xshell登录我们创建的小鸡内,跑一个测评脚本:

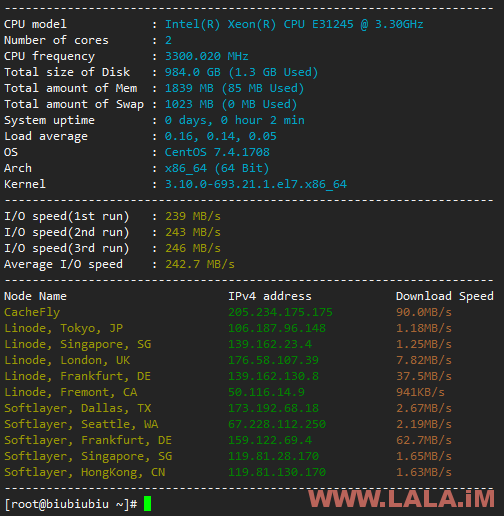

最后使用Xshell登录我们创建的小鸡内,跑一个测评脚本:  Very nice,一切都是如此的美妙~ 写在最后: 这套开VPS的方案,可以说就是目前最成熟,也最简单方便的了。然后你们可以自己脑补一下,花点钱买套WHMCS主机皮,或是找人定做一套,然后找人买几个便宜的C段,然后找机房托管几台机器,然后把IP路由一下,最后再按照我这篇文章的操作把SolusVM配置好并与WHMCS对接。你也可以做IDC。 本来不想花时间写这些东西的,但是既然IDC的门槛已经这么低了,那就不如让它再低一点,反正做这行,小打小闹谁都可以做,但是真想做规模的话,没几个能做的出来。

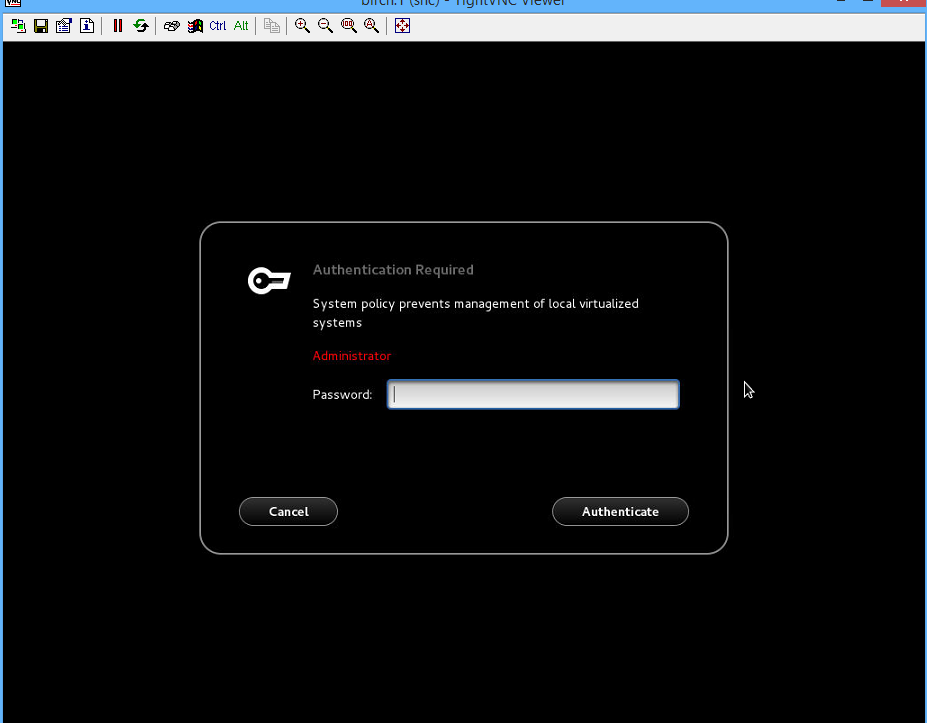

Very nice,一切都是如此的美妙~ 写在最后: 这套开VPS的方案,可以说就是目前最成熟,也最简单方便的了。然后你们可以自己脑补一下,花点钱买套WHMCS主机皮,或是找人定做一套,然后找人买几个便宜的C段,然后找机房托管几台机器,然后把IP路由一下,最后再按照我这篇文章的操作把SolusVM配置好并与WHMCS对接。你也可以做IDC。 本来不想花时间写这些东西的,但是既然IDC的门槛已经这么低了,那就不如让它再低一点,反正做这行,小打小闹谁都可以做,但是真想做规模的话,没几个能做的出来。 此时请输入您的root用户密码. 然后会提示一系列配置信息, 直接NEXT就好.

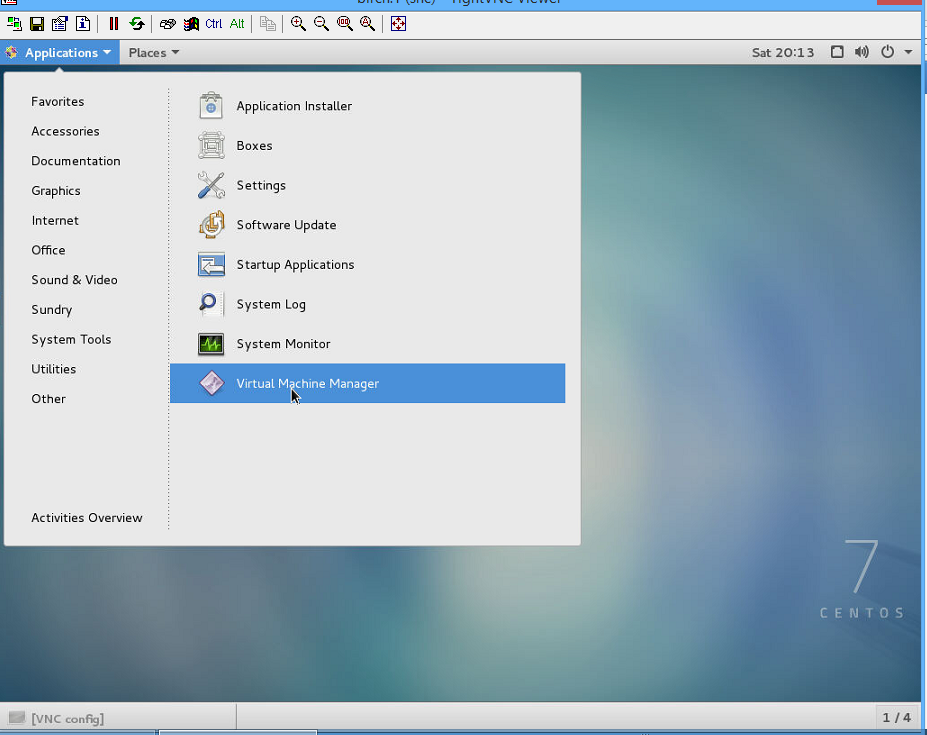

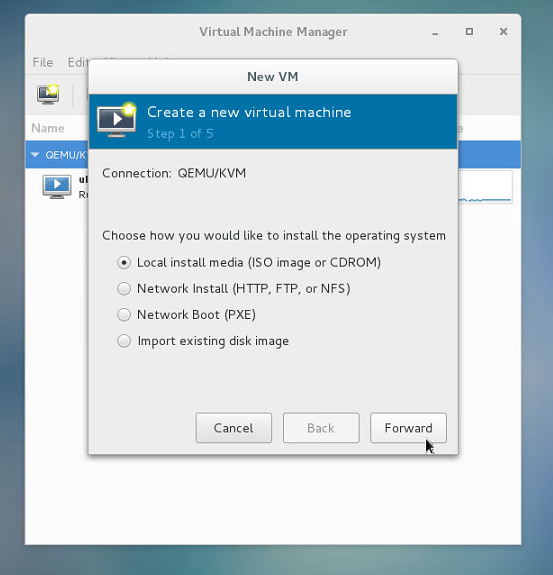

此时请输入您的root用户密码. 然后会提示一系列配置信息, 直接NEXT就好.  打开后, 点击图标Create a new virtual machine.

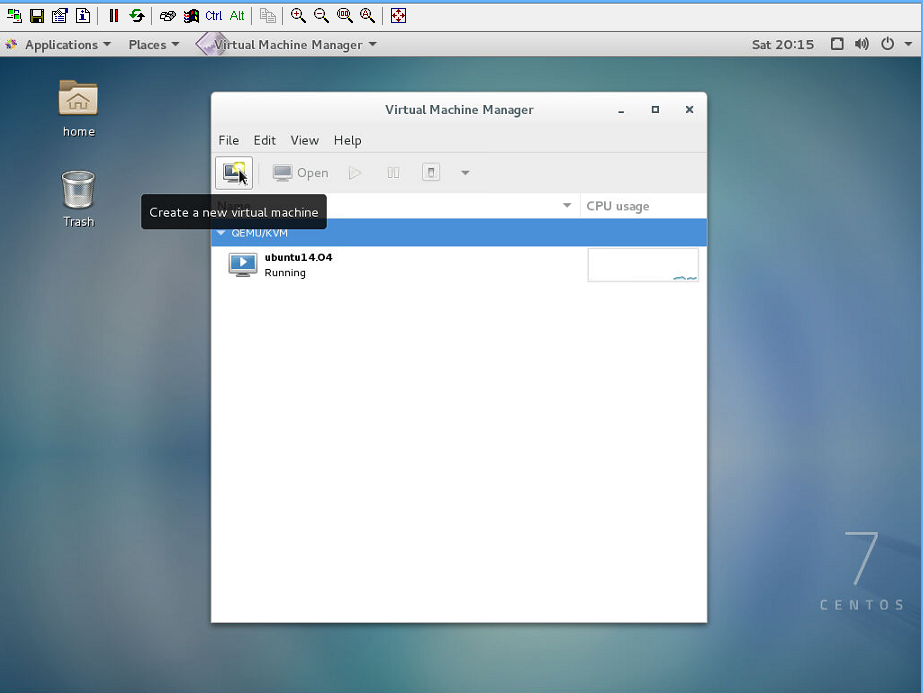

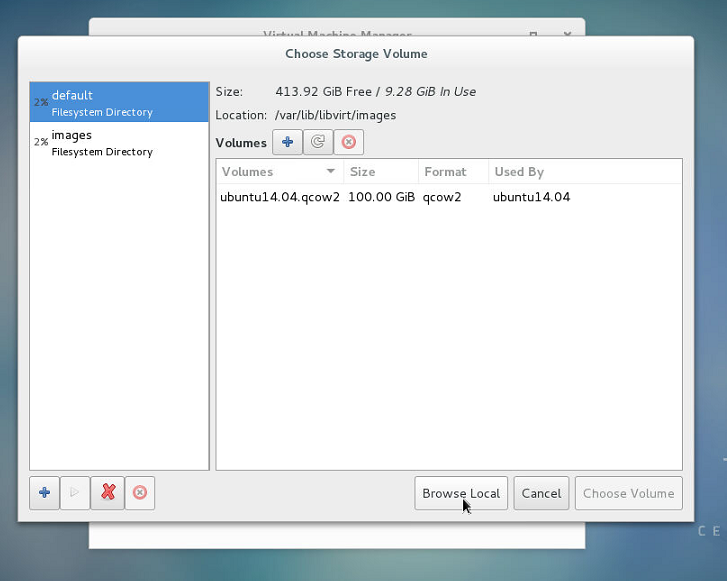

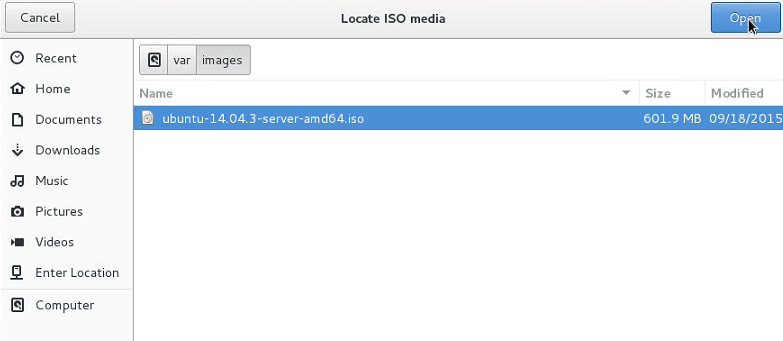

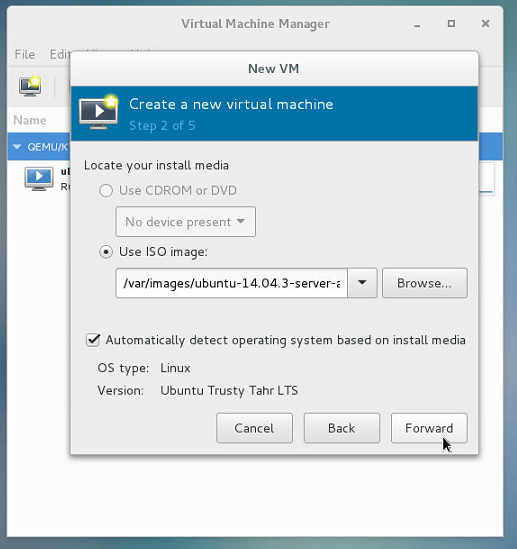

打开后, 点击图标Create a new virtual machine.  然后按步骤载入系统镜像. 如果没有系统镜像的, 可以去我的下载站

然后按步骤载入系统镜像. 如果没有系统镜像的, 可以去我的下载站

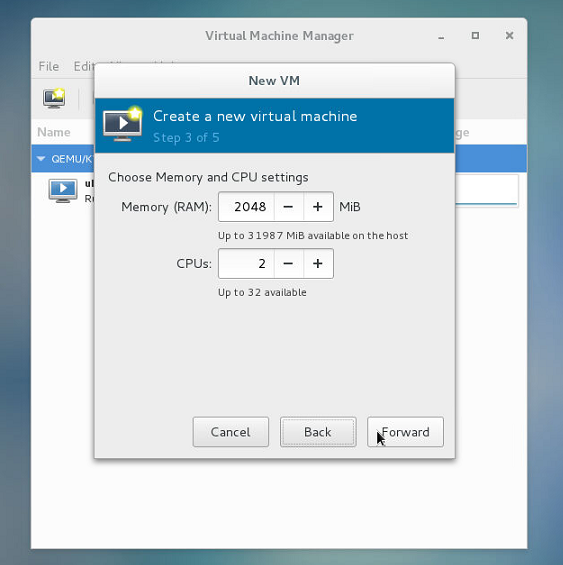

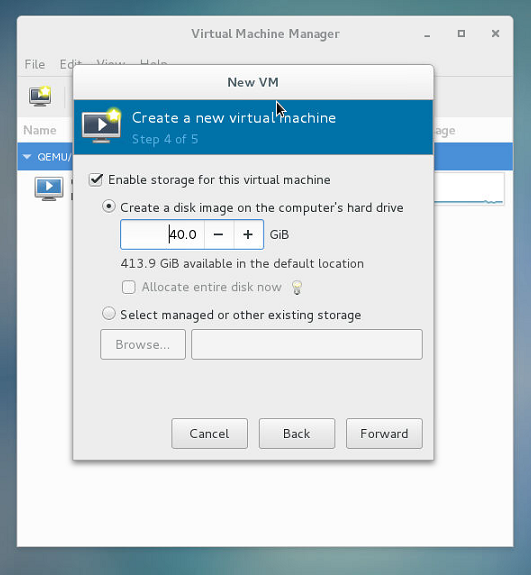

接着分配内存和硬盘. KVM是实虚拟, 因此分配内存后宿主机就不能再使用这部分资源了.

接着分配内存和硬盘. KVM是实虚拟, 因此分配内存后宿主机就不能再使用这部分资源了.

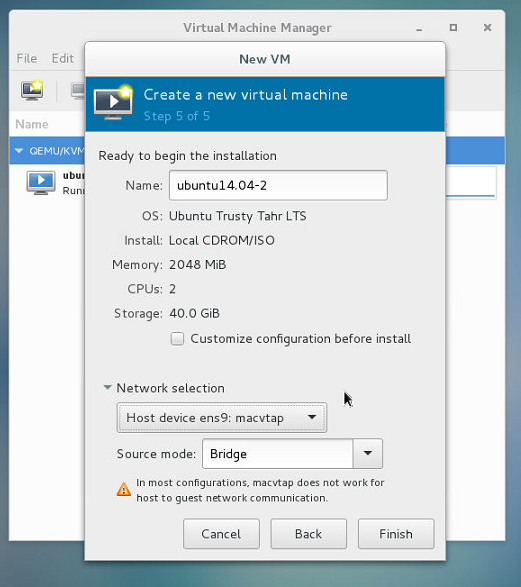

最后分配网卡. 这里我们要选择桥接模式Bridge, 并选择宿主机的出口网卡. 如下图.

最后分配网卡. 这里我们要选择桥接模式Bridge, 并选择宿主机的出口网卡. 如下图.  这样, 我们就新建完成了VPS, 可以安装操作系统了.

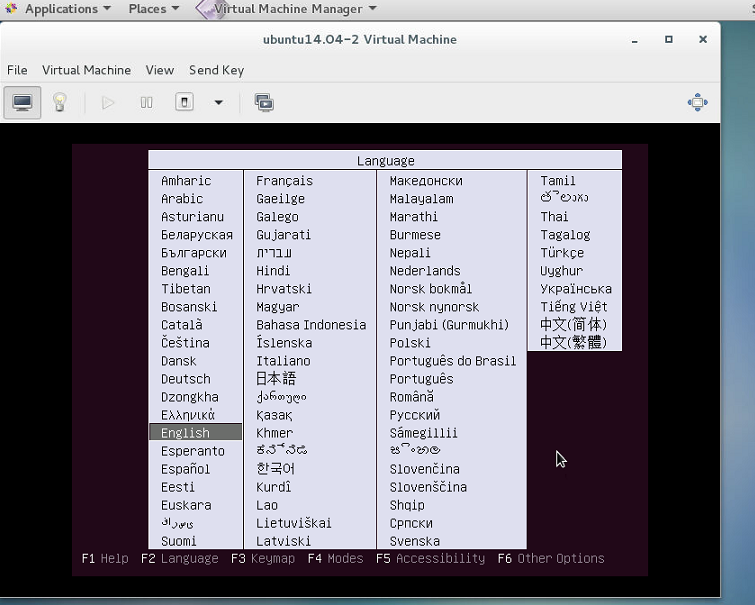

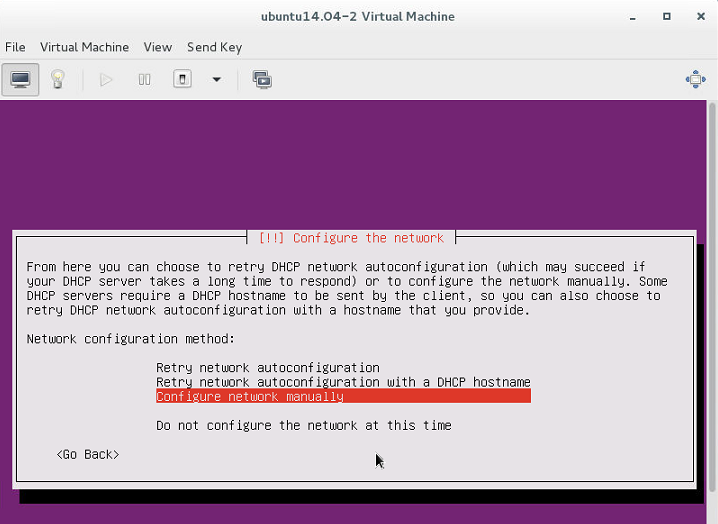

这样, 我们就新建完成了VPS, 可以安装操作系统了.  是不是很简单呢? 安装系统的时候有一个步骤是配置网络信息, 这里我们的DHCP是不生效的, 需要在VPS上获取IP. 选择Configure Network Manually, 然后按照第一部分第三小节的信息来配置即可.

是不是很简单呢? 安装系统的时候有一个步骤是配置网络信息, 这里我们的DHCP是不生效的, 需要在VPS上获取IP. 选择Configure Network Manually, 然后按照第一部分第三小节的信息来配置即可.  至此, 大功告成. 我们在VPS上安装SSH服务器后, 就可以对它进行完全独立的网络访问了.

至此, 大功告成. 我们在VPS上安装SSH服务器后, 就可以对它进行完全独立的网络访问了.